О дипфейках предложили написать статью в Гражданском кодексе

Это поможет сохранить уникальные изображения и голоса людей, в том числе защитить знаменитостей

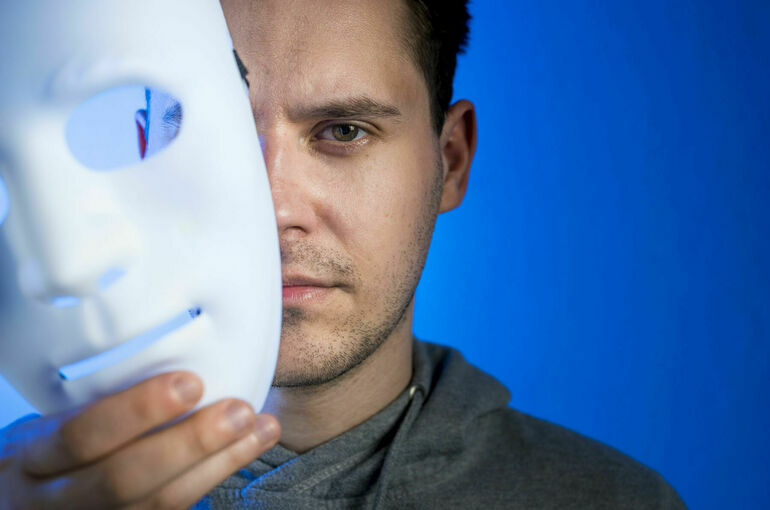

Технологии искусственного интеллекта (ИИ) способны в считанные секунды создать изображение и голос человека, как две капли воды похожие на оригинал. Это грозит новыми мошенническими схемами, считают в Совете по развитию цифровой экономики при Совете Федерации, поэтому работают над законопроектом об ограничении дипфейков. Одна из инициатив — закрепить новое понятие в Гражданском кодексе. Однако дать четкое определение дипфейку пока не могут ни законодатели, ни ученые.

Защита от опасности

Можно записать песню голосом любого исполнителя, хоть ныне живущего, хоть давно ушедшего из жизни, сгенерировав его пение с помощью искусственного интеллекта. Чтобы полностью сымитировать манеру речи человека, ИИ достаточно двухминутной записи его голоса. Аналогично генеративный ИИ работает с изображениями: он способен оживлять фото или создавать новые видео на основе имеющихся. Лицо героя будет один в один.

На днях ректору Университета Иннополис Александру Гасникову позвонил мэр Москвы Сергей Собянин — во всяком случае, на экране смартфона появилось изображение градоначальника, рассказал ученый 4 апреля на заседании секции «Искусственный интеллект» Совета по цифровой экономике при Совете Федерации. Специалист быстро распознал дипфейк и отключился, но ведь большинство людей не настолько сведущие в новых технологиях. Им, правда, и мэр вряд ли так запросто позвонит, но родственники, которые на самом деле не родственники, вполне могут. И кто знает, чем это может кончиться.

Дипфейки создаются с использованием глубоких нейросетей — это наилучшая технология, поэтому она очень опасна, отметил Гасников. В то же время в России есть методы распознавания фейков на основе математических моделей. Но их нужно постоянно совершенствовать. «Это такая бесконечная гонка вооружений, в которой нужно быть всегда на шаг впереди злоумышленников», — заключил ректор.

Имитация или фальсификация

Зампреду Совета по «цифре» при Совфеде Артему Шейкину фейковые личности, кажется, не звонили, но несколько месяцев назад к нему обратились дикторы, чьи известные голоса использовали втемную без их согласия. Тогда же сенатор на основе экспертных мнений предложил разработать законопроект, который бы позволил людям защитить их голоса. Работа над документом продолжается, рассказал Шейкин, и сейчас важно дать наиболее точное определение дипфейку. Как оказалось, сделать это непросто.

Дипфейк — это искусственная аудио- или видеозапись, созданная с помощью ИИ и позволяющая мимикрировать под человека или объект, сделал попытку прямо на заседании замдиректора департамента стратегического развития и инноваций Минэкономразвития Никита Якунов. И тут же получил возражения от ученых. Терминология дипфейка должна выстраиваться через конструкцию о введении в заблуждение при идентификации голоса или изображения человека, сказал научный сотрудник Института государства и права РАН Виктор Наумов. Но и ему возразил директор по научным проектам Высшей школы экономики Сергей Гарбук: «К идентификации все не сводится, ведь есть фейковые новости. Я бы предложил отталкиваться от слова «фальсификация», которое покрывает некорректное распространение новостей и так далее. Фейк есть фейк, дип он или не дип».

Характерные и уникальные

Над определением еще поработают, но уже есть идеи, как регулировать дипфейки — их стоит упомянуть в Гражданском кодексе, где есть статья о защите внешнего облика и изображения человека, только ее нужно расширить. В этом уверен директор Национальной федерации музыкальной индустрии Никита Данилов. Такое решение, по его словам, позволит защитить и обычных людей, и авторские и смежные права исполнителей, поэтов и композиторов.

«Дипфейк — это намеренное воспроизведение характерных и уникальных черт изображения или голоса человека, что вызывает устойчивую ассоциативную связь с ним», — предложил свой вариант определения Данилов. И добавил, что можно ввести и ряд квалифицирующих признаков дипфейка, например, использование автоматизированных технологий для создания такого образа.

Ряд экспертов, по словам Артема Шейкина, выступает за обязательное нанесение так называемых водяных знаков, то есть уведомление зрителей и слушателей, что они имеют дело с дипфейком. Но ясно, что соблюдать это правило будут лишь законопослушные люди, а мошенники так и будут клепать фальшивки без зазрения совести.

На происки злоумышленников обратил внимание и руководитель секции «Искусственный интеллект», руководитель секции человекоцентричного ИИ Сбера Андрей Незнамов: «Нужно сделать так, чтобы проектируемое регулирование не остановило развитие наших технологичных компаний. Ограничения могут им навредить, при этом злоумышленники будут использовать иностранные разработки».

Секция будет заседать еще не раз, возможно использование дипфейков разрешат в экспериментальном режиме — там, где эта технология востребована, например в рекламе или в кино. Но, как отметили участники заседания, точно потребуется урегулировать вопросы предоставления прав на голоса и изображения людей, живых или мертвых.

Читайте также:

• В Минкульте рассмотрят регулирование дипфейков в кино • Депутат Антон Немкин рассказал, как остановить распространение дипфейков

3342

3342

Ещё материалы: Артем Шейкин , Сергей Собянин